OpenAI, la société américaine derrière ChatGPT, a lancé fin décembre 2025 une offre d’emploi qui intrigue l’écosystème tech : celle de “Head of Preparedness”, ou responsable de la préparation aux risques liés à l’intelligence artificielle. Le recrutement s’inscrit dans un contexte où les capacités des modèles d’IA avancent si vite qu’il devient essentiel de suivre, anticiper et réduire les dangers potentiels que ces systèmes peuvent générer. Selon l’annonce publiée par l’entreprise, ce rôle stratégique surpasse largement le cadre traditionnel d’un recrutement technique classique, tant par ses responsabilités que par sa rémunération annuelle dépassant 555 000 USD, soit un salaire attractif avec actions en plus.

OpenAI recrute un responsable de la préparation pour gérer les risques IA

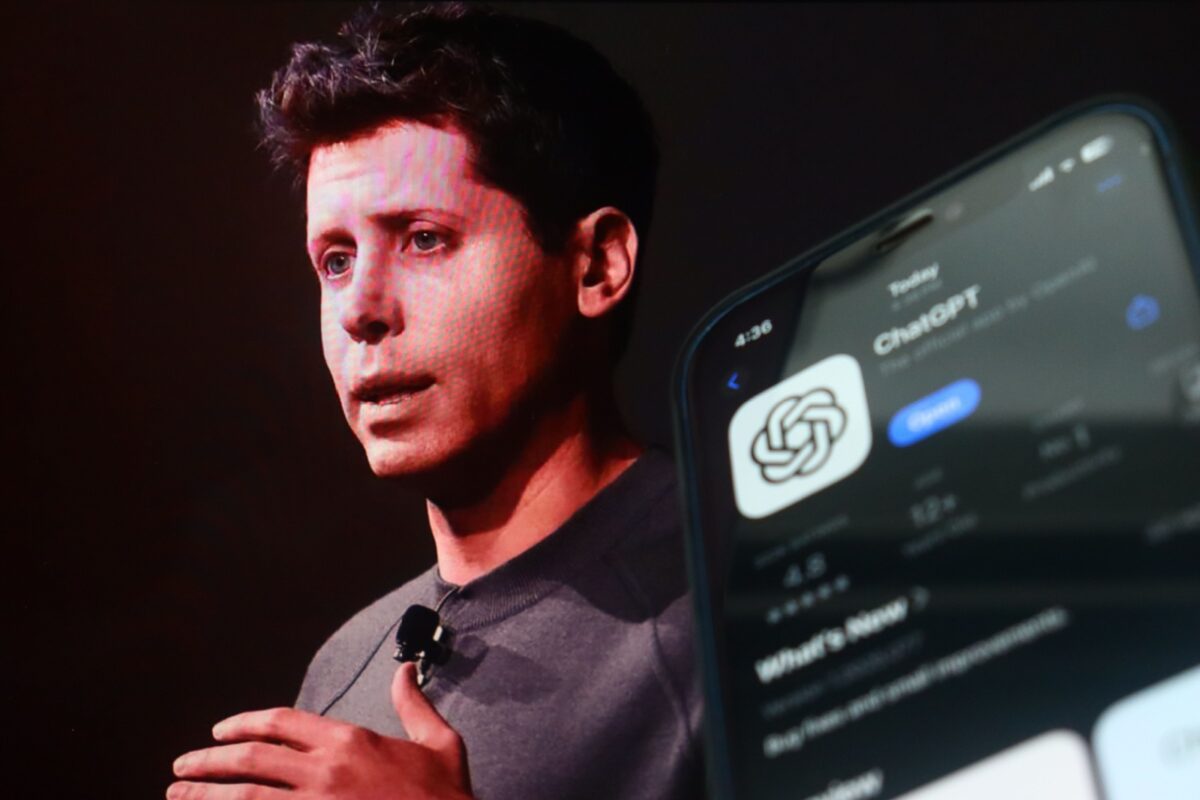

L’ouverture de ce poste de chef de la préparation arrive alors que les modèles d’OpenAI sont jugés à la fois exceptionnels et sources de préoccupations importantes. Sam Altman, directeur général d’OpenAI, a lui-même qualifié ce recrutement de fonction « critique à un moment important », car les modèles « s’améliorent rapidement et sont capables de grandes choses, mais présentent aussi des défis réels ».

Un rôle clé pour suivre l’évolution rapide des risques liés à l’IA

Chez OpenAI, le poste de responsable de la préparation est intégré à l’équipe Safety Systems, chargée d’élaborer et de maintenir les cadres de sécurité pour tous les systèmes d’IA développés par l’entreprise. Selon la description fournie par la société, la mission principale consiste à piloter la stratégie technique et l’exécution du cadre de Preparedness, c’est-à-dire l’ensemble des méthodes servant à anticiper et à se préparer aux capacités de pointe qui pourraient entraîner des risques graves.

Concrètement, le futur chef de la préparation devra construire et coordonner les évaluations des capacités des modèles, développer des modèles de menace détaillés et superviser des mesures d’atténuation qui forment ensemble une chaîne de sécurité à la fois rigoureuse et opérationnelle. Ces activités permettent de s’assurer que les résultats d’évaluation influencent directement les décisions de lancement de produits, les politiques internes et les cas formels de sécurité.

La fonction exige également une forte capacité à communiquer clairement et à exercer un jugement technique solide, car il faudra travailler de façon transversale avec les équipes internes (recherche, ingénierie, produit, gouvernance) et des partenaires externes afin d’intégrer la préparation dans toutes les phases de développement et de déploiement des technologies.

Pourquoi ce recrutement maintenant ?

Le contexte de ce recrutement est révélateur d’un tournant dans la manière dont OpenAI perçoit les risques associés à l’intelligence artificielle. Alors que les modèles deviennent plus puissants, les critiques se multiplient sur la capacité des entreprises tech à gérer les externalités négatives — effets imprévus, exploitation malveillante ou problèmes sociétaux complexes. Dans ce cadre, OpenAI met clairement l’accent sur l’anticipation plutôt que sur la réaction.

Ce rôle vise non seulement à évaluer les risques technologiques comme les vulnérabilités en cybersécurité ou les biais comportementaux, mais aussi à réfléchir à la meilleure façon de déployer ces systèmes de manière responsable. Certaines sources mettent en lumière des préoccupations touchant même la santé mentale, avec des cas où des IA conversationnelles auraient amplifié des pensées négatives chez certains utilisateurs.

Sam Altman a aussi averti que ce poste serait particulièrement exigeant, affirmant que « ce sera un travail stressant et que vous plongerez presque immédiatement dans le vif du sujet ». Cette mise en garde souligne bien l’intensité des défis techniques et éthiques associés à ce rôle, alors qu’OpenAI continue de pousser les limites de l’innovation en intelligence artificielle.

Un défi technique et humain

Plus qu’un simple poste de direction technique, ce recrutement illustre une prise de conscience accrue des enjeux globaux que pose aujourd'hui l’intelligence artificielle. Pour OpenAI, encore en phase d’expansion de ses capacités et de son influence, il s’agit maintenant de s’assurer que la croissance ne se fasse pas au détriment de la sécurité ou de la responsabilité. Le « Head of Preparedness » est ainsi positionné au cœur du débat technologique, à la croisée des chemins entre innovation rapide et gestion des risques majeurs pouvant toucher des secteurs aussi variés que la cybersécurité, la bioéthique ou encore le bien-être social.

Même si à première vue le titre peut sembler technique, il reflète une réalité plus large : celle d’une industrie en pleine maturation, où les géants de la tech doivent non seulement inventer l’avenir, mais aussi s’assurer qu’il reste sûr et bénéfique pour tous.